최근 인공지능(AI) 기술은 엄청난 발전을 이루고 있어요. 그중에서도 대형 언어 모델(LLM) 은 인공지능의 미래를 바꿀 핵심 기술로 주목받고 있는데요! 🧠✨ OpenAI의 o1 모델이 등장하면서 추론 능력이 더욱 향상되었지만, 아쉽게도 비공개 모델이죠. 😞

하지만 희소식이 있습니다! 🎉 바로 DeepSeek-R1 연구 논문이 공개되었는데요! 이 논문에서는 새로운 오픈소스 AI 모델 DeepSeek-R1이 어떻게 강화학습(RL)을 통해 강력한 추론 능력을 갖추었는지 설명하고 있어요. 🔥

1️⃣ LLM 훈련 과정 간단 정리 ✍️

LLM(대형 언어 모델)이 만들어지는 과정은 보통 3단계로 나뉘어요. 🏗️

- 사전 훈련 (Pre-training) 🏋️♂️

- 방대한 텍스트와 코드 데이터로 훈련 📚

- 다음 단어를 예측하는 방식으로 학습 🤖

- 하지만 인간의 명령을 잘 따르지는 못함 🤔

- 지도 학습 미세 조정 (Supervised Fine-tuning, SFT) 🎯

- 사람이 제공한 정답 데이터로 추가 학습 👨🏫

- 명령을 더 잘 이해하고 따를 수 있도록 개선 👍

- 강화학습 (Reinforcement Learning, RL) 🏆

- 모델이 더 나은 답변을 학습하도록 보상 시스템 적용 🎁

- 사람의 피드백(RLHF) 또는 AI의 피드백(RLAIF)을 활용 🤖➡️🤖

💡 그런데! DeepSeek-R1은 이 과정에서 SFT 단계를 과감히 생략했다고 해요! 😲

2️⃣ DeepSeek-R1-Zero: 오직 강화학습으로 훈련된 모델 🎲

논문에서는 DeepSeek-R1-Zero라는 모델을 소개하는데요. SFT 없이 오직 강화학습만으로 모델을 훈련했다고 합니다! 😮

- 기존 방식: 사전 훈련 → 지도 학습(SFT) → 강화학습(RL) 🏗️

- DeepSeek 방식: 사전 훈련 → 바로 강화학습! 🎯

🤔 "SFT 없이도 가능할까?" 라는 의문이 들 수 있는데요. 여기서 등장한 새로운 방법이 규칙 기반 강화학습입니다! 🔥

3️⃣ 새로운 훈련 방법: 규칙 기반 강화학습 🤖

DeepSeek 팀은 GRPO (Group Relative Policy Optimization) 라는 새로운 강화학습 기법을 개발했어요. 🎯

✅ 어떻게 작동할까요?

- 모델이 여러 개의 답변을 생성함 📝

- 미리 정의된 규칙에 따라 각각의 답변에 점수를 매김 📊

- 더 높은 점수를 받은 답변을 학습하여 개선함 🔄

✅ 예제 규칙:

- 정확도(Accuracy) 🎯: 수학 문제 정답 여부 체크 ✅

- 형식(Format) 🏷️: 특정 태그를 활용해 일관된 답변 생성 🔠

📌 기존 RLHF 방식과 다르게 사람이 직접 피드백을 줄 필요 없이 자동화된 방식으로 훈련 가능해요! 💡

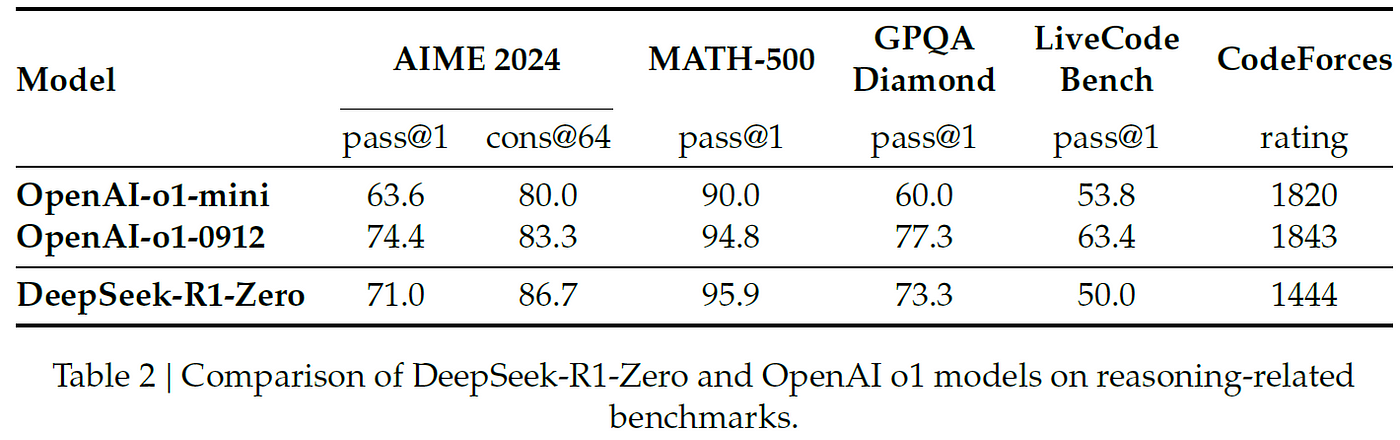

4️⃣ DeepSeek-R1-Zero의 성능은? 🚀

그럼 실제 성능은 어떨까요? OpenAI o1 모델과 비교해도 전혀 밀리지 않는 수준입니다! 😍

📊 성능 비교 (논문 데이터)

- DeepSeek-R1-Zero → 평균적으로 15.6% → 71.0% 향상! 📈

- 추론 능력이 강화되고, 문제 해결 시간이 증가하면서 'Aha Moment' 현상도 나타남 💡

- 즉, 모델이 스스로 답변을 다시 생각하고 수정하는 능력이 생김!

DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

We introduce our first-generation reasoning models, DeepSeek-R1-Zero and DeepSeek-R1. DeepSeek-R1-Zero, a model trained via large-scale reinforcement learning (RL) without supervised fine-tuning (SFT) as a preliminary step, demonstrates remarkable reasonin

arxiv.org

5️⃣ DeepSeek-R1: 더 나은 가독성을 위해 📝

DeepSeek-R1-Zero 모델이 뛰어난 성능을 보여줬지만, 가독성(Readability) 문제가 있었어요. 😵

❌ 문제점:

- 답변이 복잡하고 읽기 어려움 📖

- 여러 언어를 혼합하여 응답하는 경우 발생 🌍

👉 그래서 등장한 것이 DeepSeek-R1! 🏆

- 언어 일관성 유지 (한 가지 언어로 응답)

- 더 자연스럽고 명확한 문장 생성

결과적으로, 오픈소스 모델로서 OpenAI의 o1과 경쟁할 수 있는 강력한 AI 모델이 탄생했어요! 😃

🎯 결론: DeepSeek-R1이 중요한 이유

✅ 강력한 오픈소스 AI 모델 등장! 🏆

✅ 비싼 RLHF 없이도 강력한 추론 능력 학습 가능! 💡

✅ 연구자 및 개발자가 직접 활용할 수 있는 모델! 🧑💻

AI 모델의 새로운 시대, DeepSeek-R1과 함께! 🚀

👉 더 자세한 내용은 [논문 링크]에서 확인해 보세요! 📄

'AI 개발 > LLM' 카테고리의 다른 글

| 📌 Ollama vs Hugging Face: 어떤 차이가 있을까? (1) | 2025.01.31 |

|---|---|

| DeepSeek R1 챗봇 만들기! 🚀 AI 대화형 모델을 내 PC에서 실행하는 방법 🤖 (0) | 2025.01.31 |

| 💻 올라마(Ollama) 설치하기 가이드 🛠️ (0) | 2025.01.28 |

| 딥시크 사용법 DeepSeek R-1, 로컬 설치와 활용법 🌟 당신만의 AI 비서 만들기! (8) | 2025.01.28 |

| [AI 에이전트] 👩💻 LangGraph Studio: 에이전트 개발을 위한 첫 번째 IDE 💡 (2) | 2025.01.17 |