과적합의 문제

딥러닝 모델을 훈련시키는 과정에서 가장 큰 도전 중 하나는 과적합(Overfitting)을 방지하는 것입니다. 과적합은 모델이 훈련 데이터에 너무 잘 맞춰져서, 새로운 데이터에 대한 일반화 능력이 떨어지는 현상을 말합니다. 이 문제를 해결하기 위해 여러 기법이 제안되었으며, 그중에서도 Dropout은 가장 널리 사용되고 효과적인 방법 중 하나입니다.

Dropout 기법이란?

Dropout의 정의 📚

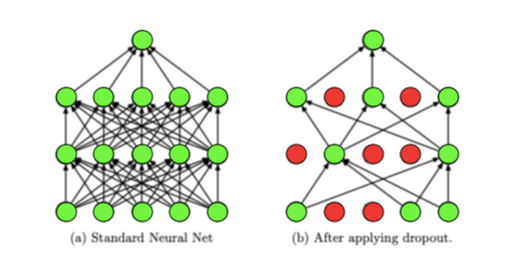

Dropout은 훈련 과정 중에 신경망의 일부 뉴런을 임의로 비활성화하여, 과적합을 방지하는 기법입니다. 이 과정에서 비활성화된 뉴런은 데이터 전파와 가중치 업데이트에서 제외됩니다. Dropout을 적용하면 모델이 특정 뉴런이나 뉴런의 조합에 지나치게 의존하는 것을 방지하고, 각 뉴런이 보다 독립적으로 유용한 특성을 학습하도록 합니다.

작동 원리 🛠

Dropout은 매 훈련 스텝마다 무작위로 선택된 뉴런을 '드롭아웃'시킵니다. 드롭아웃 비율은 일반적으로 0.2에서 0.5 사이로 설정되며, 이는 훈련 중에 각 뉴런이 비활성화될 확률을 의미합니다. Dropout을 적용함으로써, 신경망은 데이터의 다양한 표현(representation)을 학습하게 되고, 이는 모델의 일반화 능력을 향상시키는 데 도움이 됩니다.

Dropout의 장점 🌟

- 과적합 방지: Dropout은 모델이 훈련 데이터에 과도하게 적합되는 것을 방지합니다.

- 모델의 강건성 향상: Dropout을 통해 각 뉴런이 보다 독립적인 특성을 학습하게 되어, 모델의 강건성이 향상됩니다.

- 앙상블 효과: Dropout은 마치 여러 모델을 앙상블하는 것과 유사한 효과를 내어, 모델의 성능을 개선합니다.

Dropout, 딥러닝의 신뢰성을 높이다

Dropout 기법은 딥러닝 모델의 과적합 문제를 효과적으로 해결하는 간단하면서도 강력한 방법입니다. 이 기법은 모델의 일반화 능력을 향상시키고, 실제 세계에서의 성능을 개선하는 데 크게 기여합니다. 딥러닝 모델을 설계할 때, 과적합 방지를 위해 Dropout 기법을 적절히 활용하여 모델의 신뢰성과 성능을 극대화해 보세요! 🚀

'데이터사이언스(Data Science) > ML & DL' 카테고리의 다른 글

| [Machine Learning] N-gram이란 무엇인가? 텍스트 분석의 핵심 이해하기 (30) | 2024.03.13 |

|---|---|

| [Deep Learning] Early Stopping: 효율적인 머신러닝을 위한 지름길 🚦 (90) | 2024.02.25 |

| [Deep Learning] RMSprop Optimizer: 딥러닝 학습의 가속기 🚀 (33) | 2024.02.20 |

| [Deep Learning] Flatten Layer: 딥러닝 모델의 다리 역할 🌉 (34) | 2024.02.19 |

| [Deep Learning] ReLU 함수: 딥러닝의 비밀병기 🚀 (37) | 2024.02.18 |